Hochschule Harz

Prof. Frieder Stolzenburg: „Neuronale Netze funktionieren im Wesentlichen wie eine Black-Box“

Von Claudia Aldinger | 14. Dezember 2019

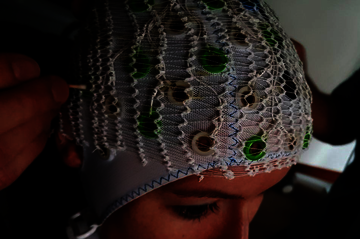

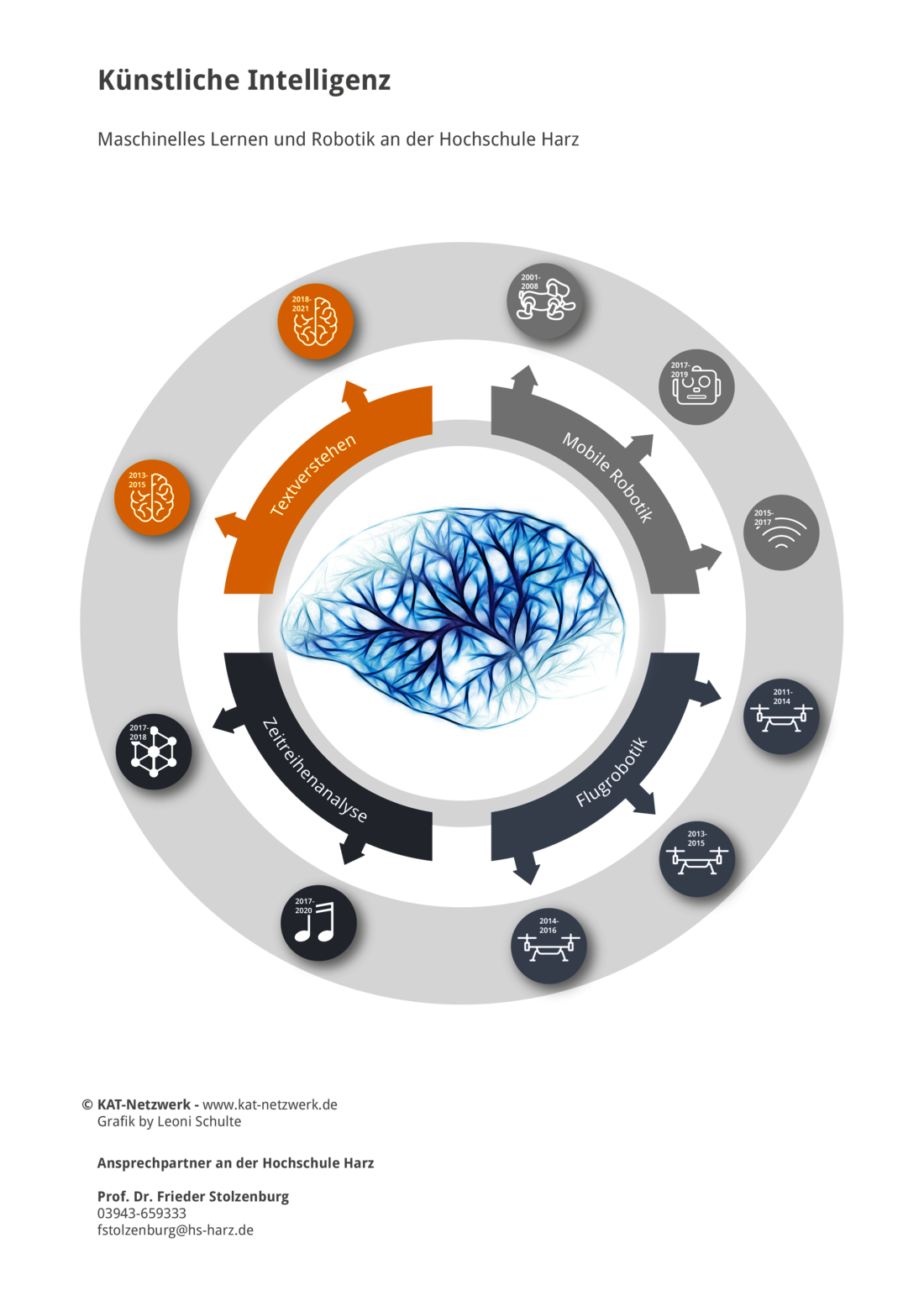

Künstliche Intelligenz (KI) entsteht heutzutage vor allem über eine Methode: Deep Learning. Maschinen werden mit Daten gefüttert, mit denen sie selbstständig trainieren und immer zuverlässiger Muster erkennen. Doch die Methode hat auch Nachteile, zum Beispiel die Notwendigkeit riesiger Datenmengen. Zudem gibt es andere Ansätze, an denen KI-Forscher arbeiten, zum Beispiel Maschinen so etwas wie gesunden Menschenverstand beizubringen (siehe dazu auch den Artikel in brandeins 2019/5 „Blick zum Horizont“). Prof. Frieder Stolzenburg ist an der Hochschule Harz berufen für das Gebiet Wissensbasierte Systeme und geht diversen Themen der Künstlichen Intelligenz nach. Seit 2018 forscht er unter anderem im Rahmen des DFG-Projekts „Cognitive Reasoning“ an neuen Ansätzen für maschinelles Lernen in Kombination mit weiteren KI-Verfahren.

Herr Prof. Stolzenburg, für wie zukunftsfähig halten Sie die Methoden des Deep Learnings?

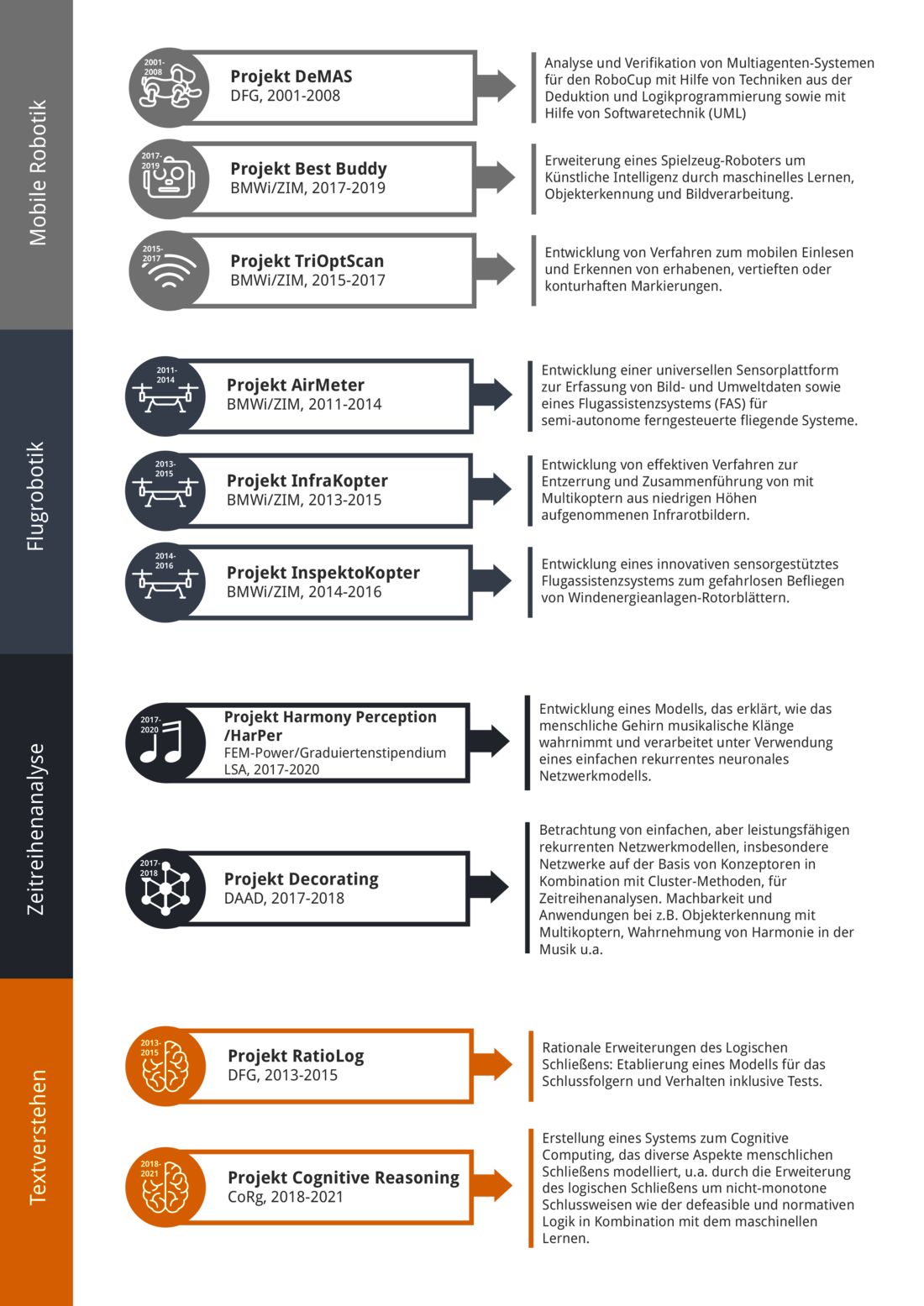

Deep Learning bezeichnet Methoden künstlicher neuronaler Netze, die eine tiefe Architektur haben, also sehr viele Neuronen, die quasi als viele kleine, parallel arbeitende Recheneinheiten zusammengeschaltet sind und so effektiv Muster und Strukturen in großen Datenmengen erkennen können. Das Gebiet der künstlichen neuronalen Netze allgemein gibt es eigentlich schon seit über 60 Jahren. Aber erst durch die heute verfügbare schnelle Computerhardware und intelligente, lokale Verarbeitung von Informationen sind sie so erfolgreich, z.B. bei der Erkennung von Objekten auf Bildern, bei der maschinellen Übersetzung, in Suchmaschinen oder bei der Qualitätsprüfung in industriellen Prozessen.

Die Präzision dieser Verfahren ist hoch. Zum Beispiel können Verkehrsschilder heutzutage recht zuverlässig und schnell durch Methoden des Deep Learning erkannt werden. Damit neuronale Netze dazu in der Lage sind, müssen sie allerdings in der Regel mit einer sehr großen Menge an Beispielen trainiert werden. Außerdem funktionieren neuronale Netze im Wesentlichen wie eine Black-Box. Erklärungen oder Begründungen, warum eine bestimmte Entscheidung getroffen wurde, fehlen. Hier besteht noch großer Forschungs- und Weiterentwicklungsbedarf auf dem Gebiet des Deep Learning. Klassische KI-Verfahren aus den Gebieten der Bildverarbeitung, der Robotik oder der Wissensverarbeitung allgemein werden dadurch auch nicht überflüssig.